Una buona analisi del rischio dovrebbe far luce su possibili minacce e predirne l’accadimento, riducendo l’incertezza del fattore di rischio. Gli sforzi, dunque, dovrebbero essere massimizzati in presenza di un tasso d’incertezza massimo. Il paradosso del rischio è che talvolta avviene il contrario e maggiore è l’incertezza, minore è lo sforzo.

Analisi del rischio, cosa si intende

Le analisi del rischio in estrema sintesi sono un aggregato di tutti i possibili fenomeni di rischio, che possano pendere sull’organizzazione. Se il singolo fenomeno è stato oggetto d’investigazione o si è verificato in passato, avrà livelli d’incertezza minori e maggiore sarà la sua comprensione e maturità di gestione degli stessi.

Al contrario se su un evento la comprensione è minima, l’incertezza è massima e ad esso dovrebbe corrispondere uno sforzo proporzionale di energie e risorse per comprendere appieno dimensioni, dinamiche, conseguenze e verosimiglianza dell’evento.

Si pensi all’inadeguatezza delle analisi dei rischi informatici e digitali per le aziende produttive, le quali d’altro canto hanno analisi approfondite per quanto concerne rischi ambientali o relativi alla sicurezza sul lavoro.

Inconsciamente, vuoi per competenze e percorso professionale, si approfondiscono ulteriormente tematiche già sufficientemente padroneggiate e si trascurano completamente fenomeni più ostici da padroneggiare, sui quali però l’incertezza è massima.

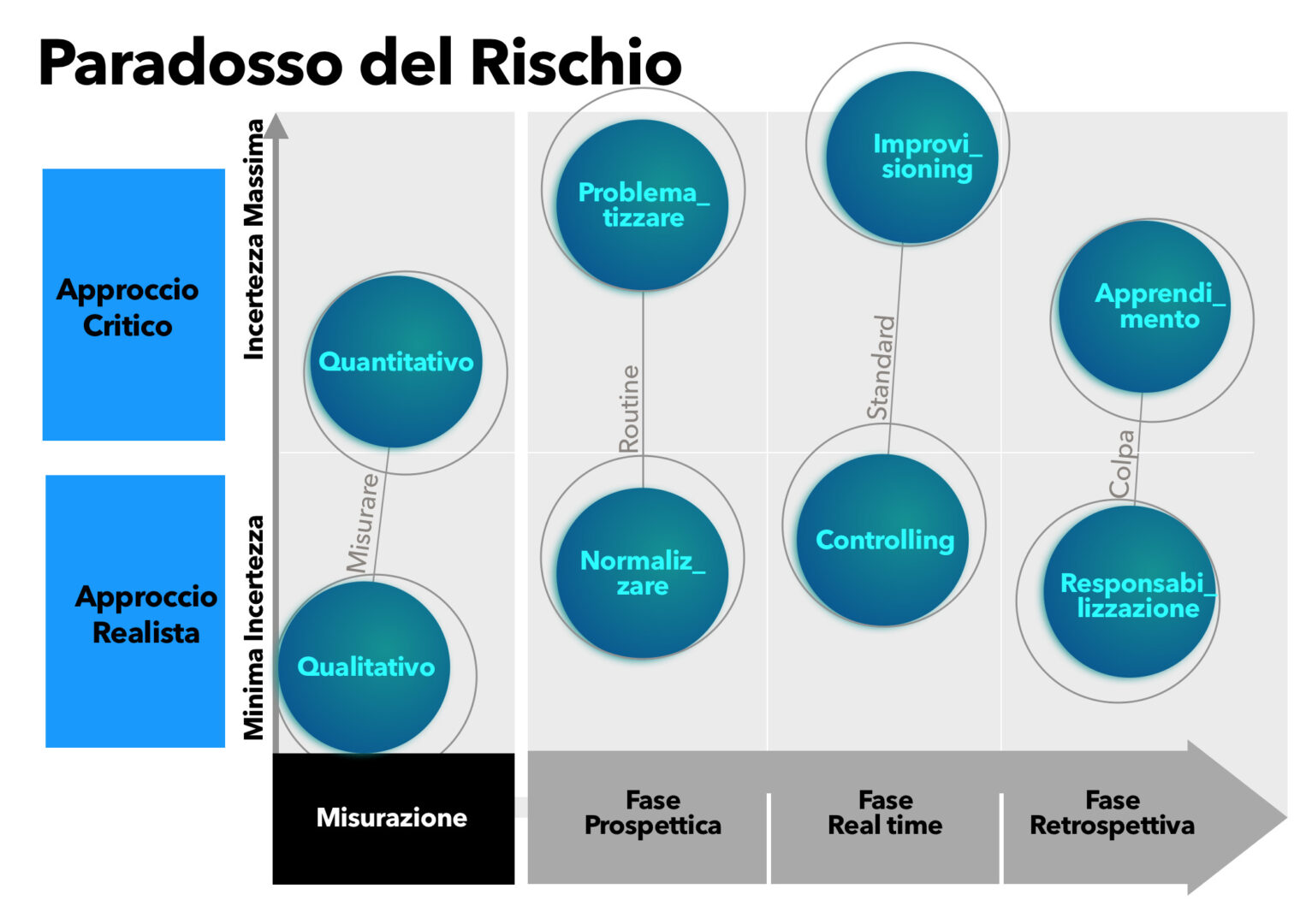

Nel prosieguo vedremo come dovrebbero essere calibrati approccio “realista” e “critico”, a seconda di quale sia il tasso d’incertezza del singolo fenomeno di rischio.

In fase prospettica, prima che l’evento si manifesti, se convenga “normalizzare” o “problematizzare”.

In fase di gestione dell’evento, se sia più utile il “controlling” o l’”improvising”.

In fase post evento, come non cadere nelle trappole della “responsabilizzazione” per migliorare l’apprendimento dell’organizzazione.

Infine se sia migliore un metodo qualitativo o quantitativo al variare dell’incertezza.

Due visioni di analisi del rischio

Vi sono due possibili diversi modi di affrontare il rischio: l’approccio realista e l’approccio critico. L’approccio realista in maniera concreta e quasi di routine si relaziona con il rischio quasi fosse un task ordinario, e di conseguenza, con una certa naturalezza e spensieratezza, lo previene, misura e gestisce. L’approccio realistico è tipico dei settori finanziari, normativi e scientifici, dove la componente rischio e la sua gestione è prassi “normale” e quotidiana.

L’approccio critico al contrario si relaziona al rischio e alla sua gestione come se fosse un task straordinario, riconoscendo e forse sovrastimandone inconsciamente incertezza, ambiguità e complessità.

La scelta su quale dei due approcci implementare spesso non è razionale ma piuttosto un’attitudine comportamentale.

Al contrario, come vedremo, ogni analista dovrebbe utilizzare pro e contro dell’approccio realista e dell’approccio critico, alla bisogna, secondo la situazione contingente e gli obiettivi che si è posto, poiché l’uno o l’atro si traducono in azioni opposte e paradossali.

Normalizzazione contro problematizzazione

In fase di analisi del rischio ex ante l’analista valuterà probabilità e impatto prima che questi si presentino. L’approccio realista tenderà a normalizzare il rischio mentre l’approccio critico al contrario lo problematizzerà.

Ovviamente entrambe le scelte hanno pro e contro.

La normalizzazione implica l’uso di tecniche consolidate, interiorizzate e modellizzate in template, excel o software ben conosciuti dall’analista e frutto della tua stratificata esperienza sul campo. Maturità che offre risorse e vantaggi ma nasconde anche insidie, quali l’illusione dell’apprendimento, la quale può lasciare soggiogati da un senso di eccessiva sicurezza e fiducia in sé stessi e nei propri mezzi. Non tutti i rischi possono essere organizzati con successo attraverso la normalizzazione, specialmente quando i rischi sono nuovi in assoluto, come nel caso della pandemia da Covid-19, dell’uso dell’intelligenza artificiale e di molti altri rischi tecnologici, oppure, se pur non nuovi in generale lo sono per lo specifico analista o per la specifica realtà. In queste situazioni “non normali” le informazioni sono complesse, contingenti e contraddittorie; l’incertezza è massima.

L’approccio critico al contrario problematizzerà piuttosto che normalizzare. Metterà in discussione valutazioni consolidate, evidenzierà le peculiarità del caso specifico, stressandone le anomalie e le difformità, investigherà lacune conoscitive dei fenomeni associati, non accetterà valutazioni consolidate e pregresse, non darà nulla per scontato. Verificherà sul campo alla ricerca di elementi trascurati o approfondirà ricerche o metodologie sperimentali, anche in ambienti non prossimi per contesto o tipologia. L’analista con approccio critico al rischio andrà alla ricerca di conoscenze, che possano integrare e, a volte, sovrascrivere le conoscenze pre-acquisite.

L’International Strategy for Disaster Reduction (ISDR), ad esempio, suggerisce in tema di rischio ambientale e/o idrogeologico di integrare le conoscenze più ortodosse con informazioni atipiche derivate dalle narrazioni indigene e/o dal folklore popolare. A Bergamo per esempio, se avessero chiesto un parere ai contadini, il nuovo ospedale non sarebbe stato costruito in un’area dove, da sempre, i raccolti sono scarsi per la tendenza all’affioramento della falda acquifera. Le polemiche e i costi, per far fronte alle infiltrazioni d’acqua nelle fondamenta dell’ospedale, probabilmente si sarebbero potute evitare con un approccio critico.

Dunque, un paradosso del rischio è che a livelli d’incertezza crescenti si dovrebbe problematizzare il rischio, attivando analisi che ne sviscerino fattori e dinamiche mentre in presenza di livelli d’incertezza minimi si dovrebbe normalizzare.

Talvolta accade il contrario e fenomeni di rischio conosciuti e perfettamente padroneggiati vengono ulteriormente investigati in una sorta di “arrovellamento” autoreferenziato, mentre situazioni di elevata incertezza non vengono approfondite perché considerate imponderabili, incommensurabili, criptiche.

Nella pratica, l’analista dovrebbe bilanciare l’uso dei due approcci e normalizzare tutti quei fenomeni consuetudinari tipici di un settore o di un’organizzazione sui quali vi è abbondanza di analisi e piena consapevolezza delle dinamiche coinvolte. Al contrario dovrebbe problematizzare e con spirito critico approfondire le aree di maggiore incertezza, per far luce su fattori di rischio inesplorati o sottostimati.

Controlling contro improvising

Il rischio talvolta potrebbe non essere stato analizzato e l’organizzazione può ritrovarsi a doverlo affrontare in real-time, dove al concretizzarsi dell’evento l’organizzazione non può fare altro che re-agire. Il modo più comune, per rispondere all’imprevisto da parte della maggior parte di noi, è mettere in atto routine istituzionalizzate, secondo una sequenza predeterminata. L’obiettivo, dovendo ricorrere ad un’immagine vivida e metaforica, è buttare acqua sulle fiamme, senza preoccuparsi troppo di quale sia il materiale o combustibile, che alimenti l’incendio. Talvolta però l’acqua non è il materiale estinguente più adatto.

Il controlling, con le sue policy, procedure, best-practice, standard, conformità, prassi, giustamente gerarchizza e regolamenta, definisce e promuove comportamenti ottimali, volti a eliminare l’improvvisazione. L’approccio realista standardizzante e normalizzante, come visto poc’anzi, è pienamente espresso nel controlling.

Ma cosa succede se il rischio si materializza inaspettatamente, in modi non previsti dai protocolli e dalle routine? E se si dovesse discostare dagli eventuali schemi previsionali? E se fosse tutt’altra cosa rispetto alle esperienze precedenti? E se fosse un “cigno nero”, un evento tanto raro da non essere nemmeno stato contemplato?

In una qualsiasi di queste situazioni, prassi, procedure e policy potrebbero non essere la risposta più adeguata. L’intuizione, il pensiero fuori dagli schemi, l’interpretare segnali deboli potrebbe essere al contrario la risposta ottimale.

Tutti ricorderanno, all’inizio della pandemia, i numerosi errori commessi, in pieno rispetto di circolari e protocolli, sia in fase di diagnosi che di posologia dei trattamenti. Molte delle successive procedure salva vite, poi introdotte, furono scritte a seguito degli insegnamenti acquisiti dalle intuizioni sul campo.

L’improvising è la capacità di capire quando la procedura è superata, per tracciare un nuovo percorso. È, dovendo fare un paragone forse improprio, abbandonare il copione ed improvvisare “andando a braccio”. Ne potrebbe uscire un discorso inebriante e carico di energia oppure la peggiore delle figure. Solo un approccio critico può generare pensieri e comportamenti di improvising.

Dunque, un paradosso del rischio è che se il controlling è quasi sempre la risposta migliore, non è sempre l’unica risposta. Detto diversamente l’improvising non è quasi mai la scelta ottimale, tranne che in alcuni casi.

Nella pratica l’analista dovrebbe bilanciare l’uso dei due approcci e utilizzare il controlling, per tutti quei casi in cui l’evento non si discosti dall’ordinario mentre al contrario dovrebbe avventurarsi nell’improvising nelle situazioni straordinarie. Ciò è possibile se una fase di pre-analisi è stata svolta correttamente e se attraverso un approccio critico ha problematizzato certi fenomeni investigandoli a fondo. Se ciò è avvenuto l’organizzazione potrà avere i mezzi per riconoscere l’evento straordinario e interpretarne segnali e circostanze, attivando energie e comportamenti non consuetudinari.

Apprendimento contro responsabilizzazione

In fase di analisi del rischio ex post, ovvero dopo che l’evento si è manifestato o la crisi è stata scongiurata per un soffio. L’analista indaga su ciò che è andato storto per migliorare la gestione futura del rischio.

Indagini, audizioni e controlli vengono implementati dopo gli incidenti per migliorare la comprensione di quanto accaduto, produrre resoconti e raccomandazioni, che da un lato siano materiale per le nuove procedure, dall’altro rassicurino e allevino l’ansia in seno all’organizzazione, fornendo spiegazioni e attribuendo responsabilità.

L’approccio realista al rischio tende inconsciamente a colpevolizzare, spesso perché la sua forma mentis, che si basa su best practice, previsioni, pianificazione, procedure, non contempla l’errore. Qualora l’errore si manifesti viene individuato non nei protocolli ma nelle persone, che da quei protocolli se ne sono discostate. Lo human factor, inteso come errore dell’agire delle persone, viene sempre considerato lato applicativo e quasi mai lato organizzativo/analitico.

L’approccio realista promuove la responsabilizzazione, che quasi sempre, ad incidente verificatosi, è interpretata non tanto nella sua accezione positiva ma piuttosto nella sua versione negativa, divenendo sinonimo di colpevolizzare. La colpa o la paura, di essere considerati i responsabili di un errore/mancanza, rafforzano la tendenza a trattenere le informazioni o a celare comportamenti/abitudini. Si innescano conflitti di attribuzione delle colpe fra colleghi o livelli gerarchici differenti, alla ricerca del capro espiatorio: La sua individuazione genera l’illusione di avere individuato la causa scatenante e minimizza l’apprendimento e la revisione del sistema.

L’approccio critico impegna l’organizzazione ad una riflessione più profonda che metta in dubbio certezze consolidate e abbracci idee radicalmente nuove. Il cambiamento non sarà volto a individuare errori puntuali, colpe di chi ha definito la strategia di gestione del rischio o di chi si è trovato a doverla applicare, bensì a ridisegnare l’intera sua gestione. Se la paura di essere ritenuti colpevoli, viene tolta dal tavolo, rimane la genuina collaborazione ad individuare ogni possibile elemento migliorativo, le informazioni circolano liberamente e la capacità di apprendimento a tutti i livelli organizzativi viene massimizzata.

Un paradosso del rischio è che la responsabilizzazione, di per sé benefica, in fase post incidente massimizza i comportamenti omertosi e minimizza la capacità di apprendimento delle organizzazioni.

Qualitativo contro quantitativo

Molte organizzazioni valutano il rischio senza misurarlo. Il rischio è una relazione matematica fra probabilità (un’altra variabile matematica) e impatto. Ci si aspetterebbe che questa relazione matematica generi un numero ma il più delle volte non è così.

Il metodo qualitativo, predominante in tutte le analisi dei rischi, prevede l’individuazione di valori, secondo convenzioni o metodologie consolidate, talvolta numerici su di una scala ad esempio da 1 a 5, talvolta descrittivi e caratterizzate da etichette ad esempio medio-alto.

Il metodo quantitativo al contrario prevede una computazione puntuale dei fattori implicati, siano essi economici per indentificare l’impatto, o statistici per individuare la probabilità di accadimento di un evento.

“Nel corso degli anni, caso dopo caso, ho scoperto che se le organizzazioni applicano l’analisi quantitativa del rischio, è su decisioni relativamente di routine a livello operativo. Le decisioni più grandi e rischiose non sono soggette a quasi nessuna analisi del rischio, almeno non a qualsiasi analisi con cui un attuario o uno statistico avrebbe familiarità. Mi riferisco a questo fenomeno come al paradosso del rischio” (D. Hubbard).

Il paradosso è che molte organizzazioni impiegano metodi di analisi del rischio abbastanza sofisticati su problemi particolari; ad esempio, gli attuari di una compagnia di assicurazioni definiscono i dettagli di un prodotto assicurativo, gli statistici analizzano il rating di un nuovo programma televisivo e i responsabili di produzione utilizzano simulazioni per modellare i cambiamenti nei metodi di produzione. Ma queste stesse organizzazioni non applicano abitualmente quegli stessi sofisticati metodi di analisi del rischio a decisioni molto più grandi con maggiore incertezza e un significativo potenziale di perdita.

Una delle obiezioni principali all’uso delle analisi quantitative è come o dove reperire i dati. L’assenza di dati quindi porta a propendere per analisi qualitative, la presenza di dati e serie storiche fa propendere per l’analisi quantitativa.

Il paradosso quindi è che fenomeni ben conosciuti e di routine, con livelli d’incertezza minima, sui quali si possiedono serie storiche, vengano gestiti in maniera complessa e sofisticata con accurate analisi quantitative, suffragate da modelli matematici e simulazioni, mentre al contrario fenomeni nebulosi, poco chiari, sui quali non si hanno informazioni, misurazioni o dati da processare, vengano gestiti con valutazioni soggettive e grossolane imputazioni su scale a 4 o 5 fattori.

Il paradosso è che maggiore è l’incertezza e minore è l’analisi di tale incertezza.

Conclusioni

In una situazione di incertezza moderata, in presenza ad esempio di un fenomeno ben conosciuto, il miglior approccio è quello ordinario fatto di una normalizzazione delle attività, di una puntuale organizzazione di procedure e prassi, di una responsabilizzazione dei task. La misurazione del fenomeno potrebbe essere sia quantitativa che qualitativa. Nel caso si optasse per quella quantitativa, dati, andamenti, serie storiche dovrebbero essere a disposizione dell’organizzazione, se non internamente, a livello di report di settore. Nel caso si optasse per quella qualitativa, la valutazione dell’analista sarebbe comunque ben calibrata e la descrizione delle valutazioni fatte puntuale e pertinente, in linea con una maturità di gestione del fenomeno di rischio.

In una situazione di incertezza elevata, in presenza di un fenomeno semisconosciuto o non sufficientemente compreso, il miglior approccio è quello critico, fatto di una problematizzazione delle attività. Policy e procedure conseguenti potrebbero incorporare in sé una certa aleatorietà, non potendo fare affidamento su una sufficiente maturità organizzativa. In caso di evento avverso l’organizzazione dovrà poter incorporare una certa dose di flessibilità applicativa e in fase investigativa post evento rivedere il sistema nel suo complesso e non nelle mere responsabilità applicative.

La misurazione, in situazione di incertezza elevata, dovrà essere quantitativa. Lo sforzo potrebbe essere significativo, poiché il reperimento dei dati potrebbe essere ostico. L’investigazione del fenomeno e la sua graduale misurazione, prima con valori stimati o recuperati all’esterno, poi con misurazioni endogene e serie storiche, sarà il più significativo e importante sforzo di riduzione dell’incertezza.